准备工具

1.电脑或服务器一台(win7操作系统以上,不支持win7)

2.灵活的双手

3.聪明的大脑

服务器可以用:微软远程桌面

工具包下载:

Python 官网:Welcome to Python.org

MediaCrawler :GitHub – NanmiCoder/MediaCrawler: 小红书笔记 | 评论爬虫、抖音视频 | 评论爬虫、快手视频 | 评论爬虫、B 站视频 | 评论爬虫、微博帖子 | 评论爬虫

node.js :Node.js — Run JavaScript Everywhere (nodejs.org)

指令合辑:

python310\python.exe -m venv venvcall venv\Scripts\activate.batpip install -r requirements.txtplaywright installpython main.py --platform dy --lt qrcode --type detail注意事项:

1.爬虫禁止非法使用,非法使用与作者无关,与葫芦侠无关

2.禁止使用该Python脚本从事任何非法行为,否则自行承担后果

3.安装过程有不懂的可以问

MediaCrawler

可以实现小红书爬虫,抖音爬虫, 快手爬虫, B站爬虫, 微博爬虫。

目前能抓取小红书、抖音、快手、B站、微博的视频、图片、评论、点赞、转发等信息。

教程开始

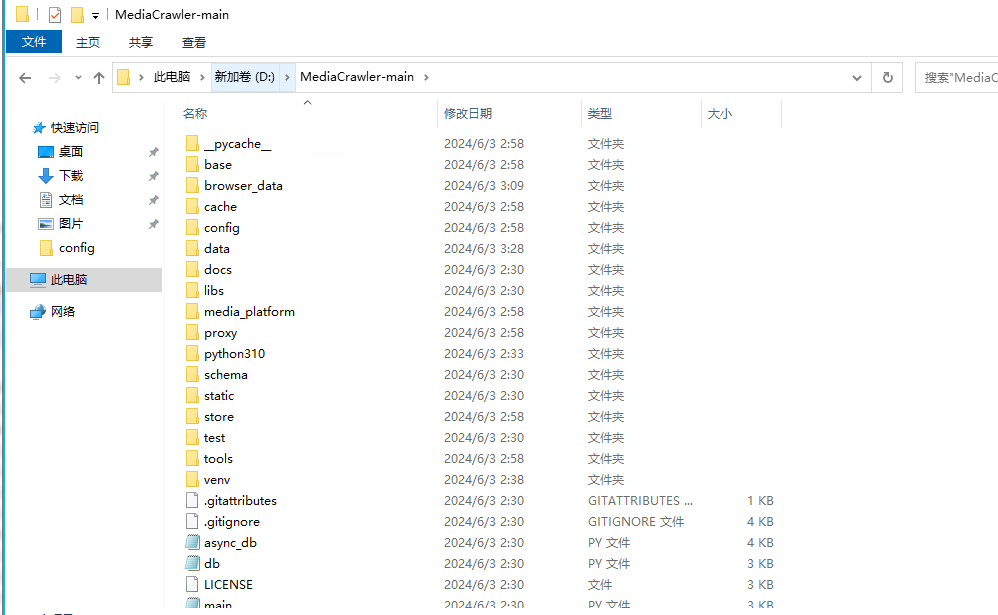

1.解压MediaCrawler包

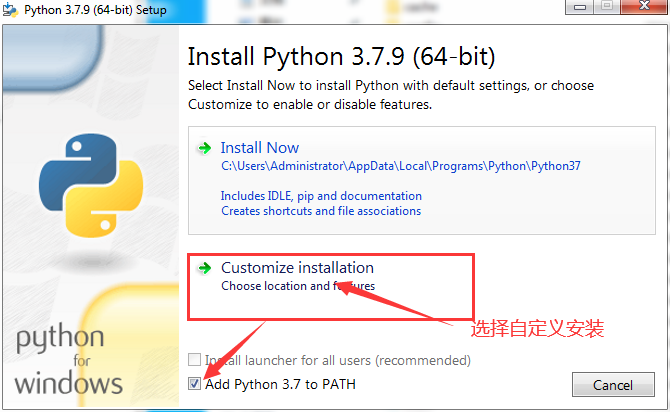

2.安装python3.10.11,在MediaCrawler目录下创建Python310目录并安装

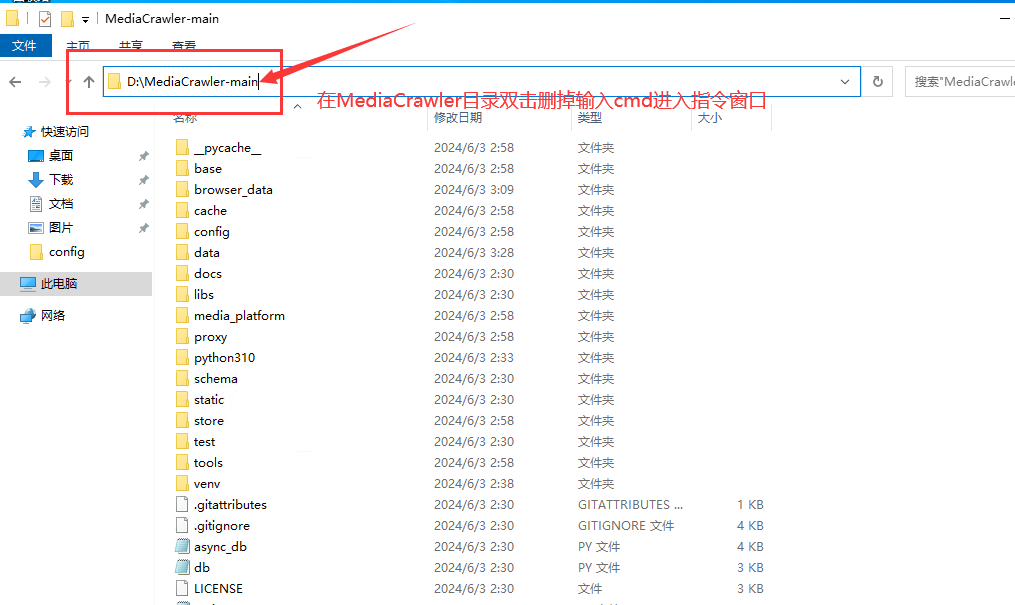

3.安装成功后打开cmd命令窗口

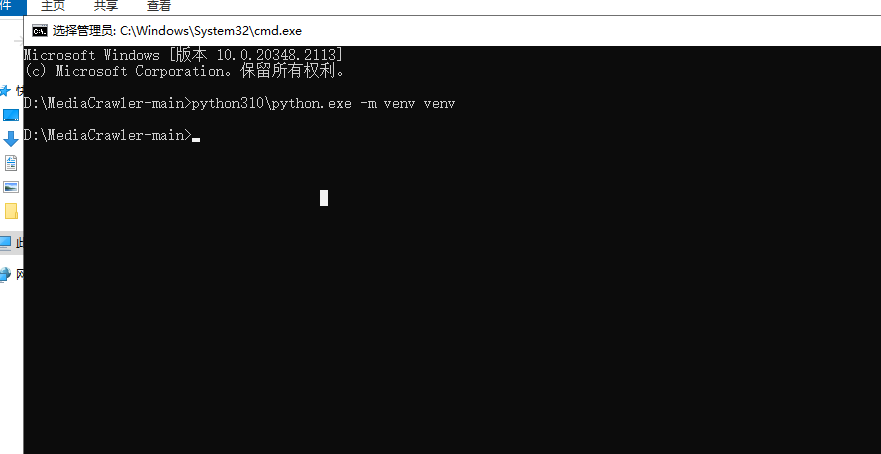

4.创建venv虚拟环境,在命令窗口输入命令

python310python.exe -m venv venv等待30-60秒弹出新的输入行即可

5.激活venv 命令

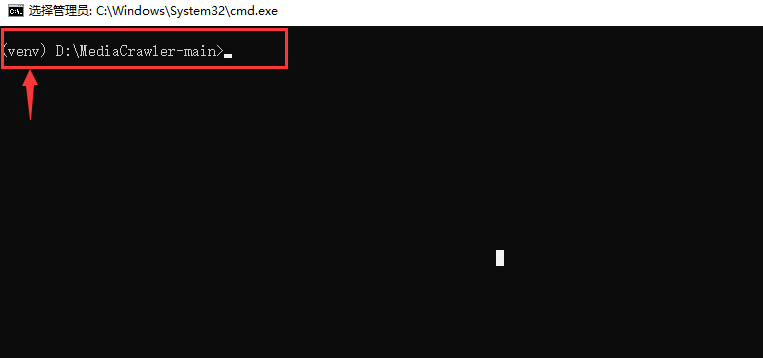

call venv\Scripts\activate.bat激活venv

激活后前面会有(venv)则表示激活成功

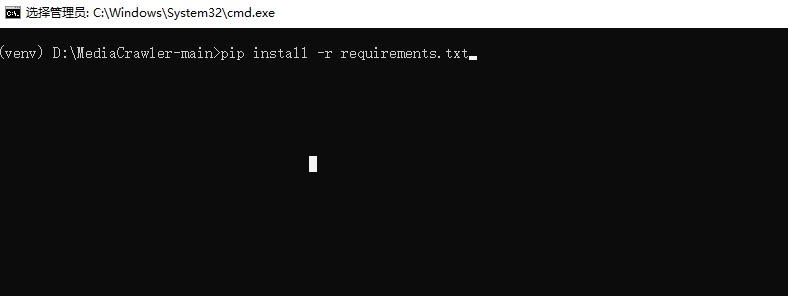

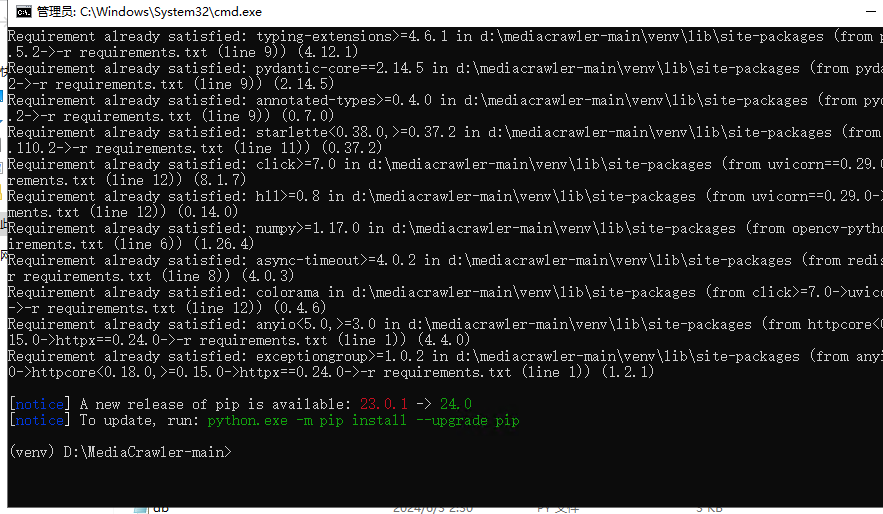

6.安装依赖库,继续输入指令

pip install -r requirements.txt执行后等待5分钟左右直到有绿色文字出现表示安装成功

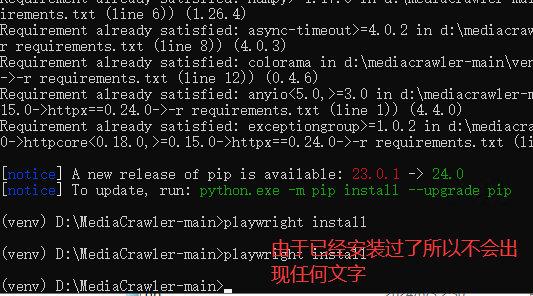

7.安装浏览器内核,输入指令

playwright install安装完成后窗口不要关闭

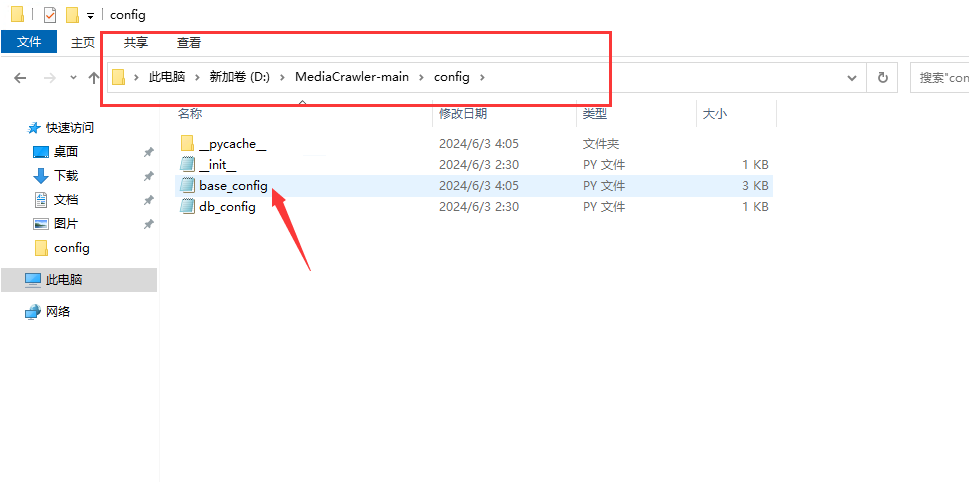

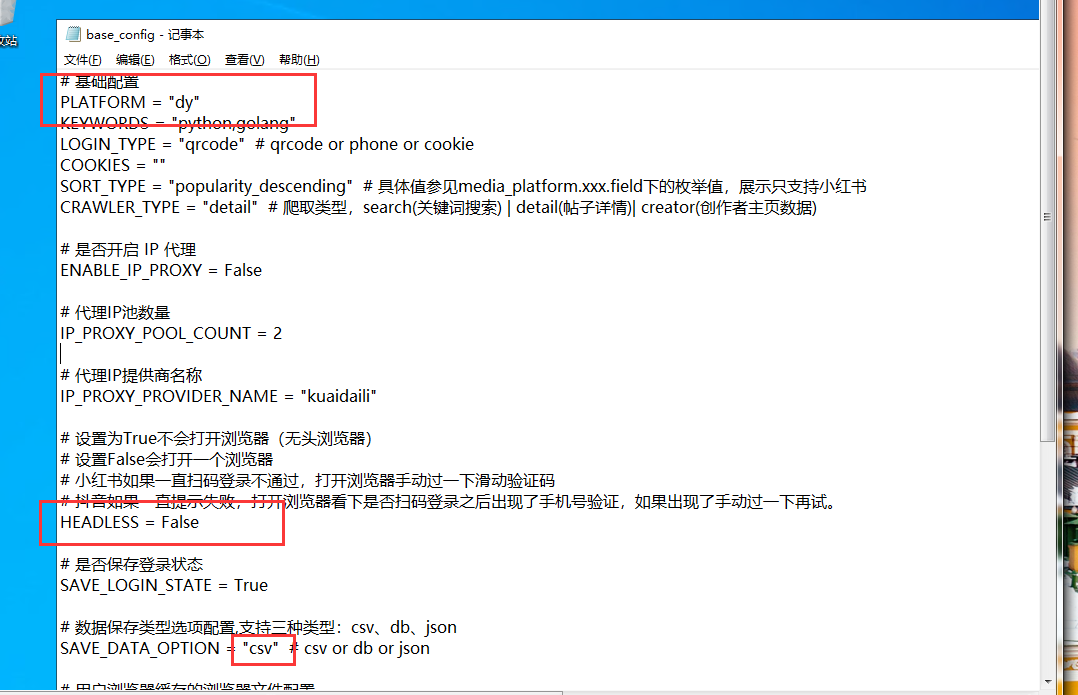

8.修改配置文件,MediaCrawler-mainconfig目录下的base_config.py用记事本打开编辑,PLATFORM对应平台(dy,ks,xhs,wb,bili)CRAWLER_TYPE爬取类型(search,detail,creator)HEADLESS设置False,SAVE_DATA_OPTION数据导出设置CSV(json和db可自行设置),ENABLE_GET_COMMENTS爬取评论设置True

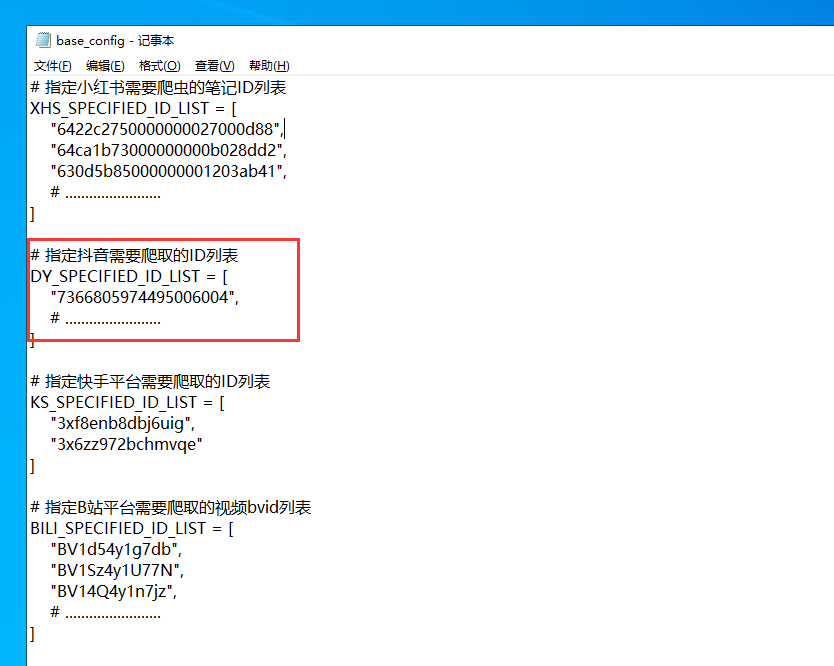

9.设置需要爬取的抖音视频ID,获取抖音视频ID:将抖音视频分享链接用浏览器打开加载完后video/后面的数字就是抖音视频ID,替换原有的视频ID即可

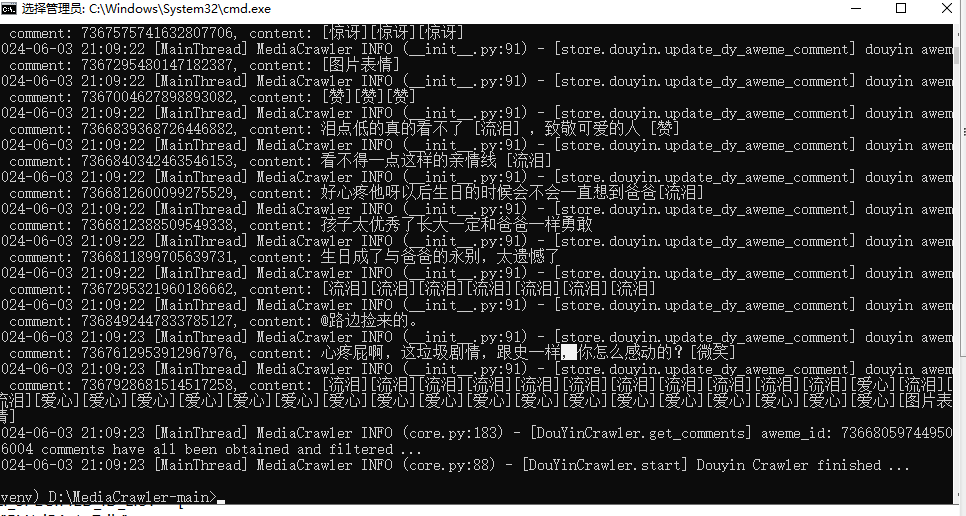

10.运行爬取抖音评论指令 python main.py –platform dy –lt qrcode –type detail,运行指令后不要扫画图里面的二维码,扫浏览器里面的二维码登录,登录后选择保存登录信息,爬取后的数据在MediaCrawler-main/data目录

11.如果步骤10执行后报错的话需要安装nedo.js

步骤10, 指令里面的dy可修改为ks,xhs,wb,bili对应不同平台,qrcode是扫码登录不要修改,手机号登录很麻烦。detail是爬取视频/帖子可修改search是搜索爬取,creator是发布者信息

爬取结果csv文件是表格文件需要用WPS查看或者其他办公软件

用户38599038 12个月前0

还会更新吗用户42327002 12个月前1

解压密码是多少啊用户67068886 12个月前4

nb确实nb就是哥可以换一个网盘嘛网速限制😂太恶心了kk牛波一1年前7

必须支持,太给力了帕格劳劳1年前0

真不错!点赞点赞!一位 WordPress 评论者1年前0

您好,这是一条评论。若需要审核、编辑或删除评论,请访问仪表盘的评论界面。评论者头像来自 Gravatar。